En esta breve introducción, exploraremos en profundidad la complejidad temporal de la búsqueda binaria, un algoritmo eficiente y potente ampliamente utilizado en informática y programación. Descubriremos cómo este método revoluciona la forma en que buscamos elementos en conjuntos de datos voluminosos, permitiéndonos comprender su funcionamiento y aplicaciones con mayor claridad. ¡Acompáñanos en este emocionante viaje a través de la búsqueda binaria!

La complejidad de la búsqueda binaria en algoritmos

Por otro lado, la **complejidad** de la búsqueda binaria se mide en el **peor de los casos**. En el peor escenario, el elemento buscado no se encuentra en la lista; en este caso, la búsqueda binaria tiene una complejidad de tiempo de **O(log n)**.

Esto contrasta con la búsqueda lineal, que tiene una complejidad de tiempo de **O(n)** en el peor de los casos, donde se debe recorrer uno por uno cada elemento de la lista.

La tabla a continuación compara la complejidad de la búsqueda binaria y la búsqueda lineal:

| Búsqueda Binaria | Búsqueda Lineal | |

|---|---|---|

| Peor Caso | O(log n) | O(n) |

La eficiencia de la búsqueda binaria la convierte en una excelente elección para buscar elementos en conjuntos de datos grandes y ordenados, ya que reduce significativamente el número de comparaciones necesarias para encontrar un elemento.

Guía sobre la complejidad temporal de un algoritmo

La complejidad temporal de un algoritmo se refiere a la cantidad de tiempo que un algoritmo tarda en completarse en función de la cantidad de datos de entrada que recibe. Esta complejidad es crucial para evaluar la eficiencia de un algoritmo, ya que nos permite prever su rendimiento conforme los conjuntos de datos se hacen más grandes.

La complejidad temporal se clasifica en diferentes tipos, siendo los más comunes el mejor caso, el peor caso y el caso promedio. Conocer la complejidad temporal de un algoritmo nos ayuda a comprender cuánto tiempo tomará la ejecución en el peor de los escenarios y cómo puede variar en situaciones ideales.

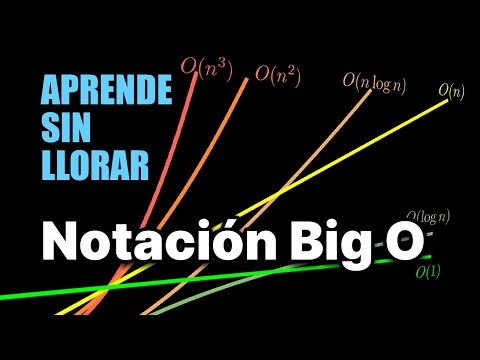

Para representar la complejidad temporal, se utilizan notaciones como O(1), O(log n), O(n), O(n log n), O(n^2), entre otras. Estas notaciones nos indican cómo crece el tiempo de ejecución del algoritmo a medida que aumenta el tamaño de los datos de entrada.

Es importante saber interpretar estas notaciones. Por ejemplo, O(1) representa un tiempo constante, donde la ejecución no depende del tamaño de los datos. Por otro lado, O(n^2) implica un crecimiento cuadrático, lo cual puede ser problemático para conjuntos de datos grandes.

Algunos ejemplos prácticos de complejidades temporales incluyen:

- O(1): Acceder a un elemento específico en un array mediante su índice.

- O(n): Recorrer una lista de elementos una vez para realizar una operación en cada uno.

- O(n^2): Realizar una búsqueda exhaustiva en una matriz bidimensional.

A la hora de diseñar algoritmos, es fundamental tener en cuenta la complejidad temporal, ya que nos permite elegir la mejor solución para un problema dado en términos de eficiencia y rendimiento.

La complejidad temporal en algoritmos.

La **complejidad temporal en algoritmos** se refiere a la cantidad de tiempo que un algoritmo tarda en ejecutarse en función del tamaño de la entrada. Se suele medir en términos de la cantidad de operaciones básicas que realiza un algoritmo en relación con el tamaño de los datos de entrada.

Existen diferentes notaciones para clasificar la complejidad temporal de un algoritmo. Algunas de las más comunes son:

- O(1): Indica una complejidad constante, es decir, el tiempo de ejecución no varía con el tamaño de la entrada.

- O(log n): Complejidad logarítmica, común en algoritmos de búsqueda binaria.

- O(n): Complejidad lineal, el tiempo de ejecución crece de forma proporcional al tamaño de la entrada.

- O(n log n): Usual en algoritmos de ordenación eficientes como Merge Sort o Quick Sort.

- O(n^2): Complejidad cuadrática, común en algoritmos de burbuja o selección.

Las **tablas** también pueden ser útiles para visualizar la relación entre el tamaño de la entrada y el tiempo de ejecución de un algoritmo:

| Tamaño de la entrada (n) | Complejidad temporal |

|---|---|

| 10 | O(1) |

| 100 | O(log n) |

| 1000 | O(n) |

En cuanto a ejemplos de código, podríamos mostrar la implementación de un algoritmo con diferentes complejidades para ilustrar cómo influye en el tiempo de ejecución, por ejemplo:

def algoritmo_constante():

return "Complejidad O(1)"

def algoritmo_lineal(n):

for i in range(n):

print(i)

return "Complejidad O(n)"

def algoritmo_cuadratico(n):

for i in range(n):

for j in range(n):

print(i, j)

return "Complejidad O(n^2)"

print(algoritmo_constante())

print(algoritmo_lineal(10))

print(algoritmo_cuadratico(10))

Estos ejemplos ayudan a entender cómo la elección de un algoritmo con una complejidad adecuada puede impactar significativamente en el rendimiento de una aplicación.

Descubrir la esencia de la búsqueda binaria lleva a comprender la importancia de su complejidad temporal. Profundicemos juntos en esta fascinante exploración matemática. ¡Hasta pronto, querido lector!